Hoy sí. Hoy toca la

antimateria y cómo es tratada en el libro Ángeles y Demonios. Antes de empezar, conviene explicar qué demonios es la antimateria.

Como todos sabemos, toda la materia está formada por

átomos. A su vez, los átomos están formados un

núcleo de

protones y

neutrones, y

electrones que dan vueltas alrededor de él. Existen además muchas otras partículas subatómicas, como el

neutrino o la

partícula Z de la que

hablé hace un par de días. Las partículas subatómicas tienen una serie de propiedades de las que las más conocidas son la masa y carga eléctrica (que puede ser nula, como en el caso del neutrón). Pero tienen además otras propiedades algo menos conocidas por los profanos, y más "exóticas", con nombres bastante peculiares. Pues bien, por cada tipo partícula, existe (o puede existir) otra con la misma masa pero con el resto de propiedades de distinto signo (excepto el

espín). Por ejemplo, el electrón tiene carga electrica negativa, y su

antipartícula, el

positrón (o antielectrón), tiene igual masa que el electrón, pero carga positiva.

La antimateria estaría formada entonces por antipartículas. Podemos imaginar un "antiátomo" formado por un núcleo de

antiprotones y

antineutrones, con positrones dando vueltas alrededor de él.

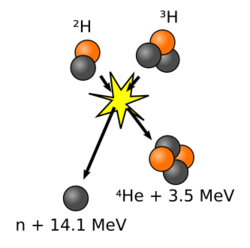

Lo interesante de todo esto es que cuando una partícula colisiona con su correspondiente antipartícula, se aniquilan mutuamente, emitiendo una cantidad de energía que viene dada por la conocidísima ecuación de Einstein

E=mc2, donde

E es la energía desprendida,

m la masa de las partículas, y

c la velocidad de la luz. Teniendo en cuenta que la velocidad de la luz es 300.000.000 m/s y que además está elevada al cuadrado, podemos ver que con una pequeña cantidad de masa se pueden conseguir cantidades increíbles de energía.

Empecemos ahora con las afirmaciones del libro. El primer gran error es la motivación que tiene el asesinado padre de Vittoria para obtener antimateria. Según él, la crear antimateria, estaría creando algo de la nada, lo que demostraría que la creación es posible, y que el

Big Bang fue creado de la nada. Bueno, cualquiera con un mínimo conocimiento de física puede entender que hay algún tipo de trampa en esta afirmación. Uno de los pilares fundamentales de la física, del que todos hemos oído hablar es el famoso

principio de conservación de la energía. "La energía ni se crea ni se destruye, sólo se transforma". Esta es una ley inviolable. Debemos entender el concepto de energía de forma muy amplia, es decir, según la ecuación

E=mc2, la masa también es energía. Eso quiere decir que para "crear" antipartículas (con sus correspondientes partículas), debemos aplicar la misma increíble cantidad de energía que se desprende en su aniquilación. De hecho, necesitamos más, ya que nuestras máquinas no son eficientes al 100%, por lo que siempre se perderá parte de la energía (como ocurre con todas las máquinas existentes). La antimateria no se crea, sino que se obtiene a partir de la energía.

Esto no lleva directamente a otro error. Puesto que necesitamos aportar más energía para crearla, de la que obtenemos con su aniquilación, la antimateria no puede ser nunca una fuente de energía. En el mejor de los casos, podría utilizarse como batería, y para eso primero hay que solucionar otros problemas, como su contención. La única forma en la que la antimateria podría covertirse en fuente de energía, es que la encontremos ya hecha, en estado natural, en alguna parte. Pero está claro que en la Tierra no va a ser, pues se aniquilaría inmediatamente al entrar en contacto con la materia (incluso con el aire). Tendríamos que encontrarla en el espacio. Y eso si la encontramos.

Otro error bastante importante, es el asombro del director del

CERN ante la afirmación de que Vittoria y su padre habían creado antimateria. Se dice que son los primeros especímenes de antimateria del mundo. Lo cierto es que el CERN y otras instituciones crean antipartículas de forma casi rutinaria en sus experimentos (y de forma distinta a como explica al libro, y no en el

LHC, que aún no está operativo). Y muchísmo antes, allá por 1932, ya se habían detectado las primeras antipartículas. La fabricación de antimateria no debería ser ninguna novedad para un científico, y mucho menos, para el director del CERN.

La contención de la antimateria es otra de las cosas que tiene miga. Dado que no puede estar en contacto con la materia, la única forma conocida de almacenarla es mediante campos magnéticos, como dice el libro. Pero para ello, lo que se pretende retener debe tener carga eléctrica. Esto no es problema si queremos almacenar unos cuantos positrones, por ejemplo. Pero no podríamos hacerlo con antineutrones. En la novela, al hablar con el comandante de la Guardia Suiza, Vittoria dice que la única marca química que podrían haber detectado es la del hidrógeno. Esto sugiere que la "gota" de antimateria que tienen no son simplemente antipartículas a granel, sino átomos de

antihidrógeno. Puesto que cada átomo tendría un antiprotón y un positrón, la carga eléctrica global sería neutra, por lo que un campo electromagnético no funcionaría. De hecho, a la hora de almacenar antipartículas, el que deban tener la misma carga eléctrica limita la cantidad que se puede almacenar, ya que éstas se repelen entre sí (creo que no hace falta explicar que cargas opuestas se atraen y cargas iguales se repelen). Para almacenar antimateria en cantidades apreciables, habría que buscar alguna otra solución (de momento desconocida).

Otro error es que en el libro se dice varias veces que la antimateria es inestable. La antimateria no es inestable

per se. Cierto que en contacto con la materia se aniquila, pero uno puede imaginar un planeta de antimateria, con su atmósfera de antioxígeno y antinitrógenos, con formas de vida basadas en anticarbono, viviendo felices y sin problemas. Claro que si existiera un lugar así, el más pequeño meteorito de materia sería devastador para el "antiplaneta". Es más, podemos imaginar un universo entero formado por antimateria (como la famosa

zona negativa que aparece en los cómics de los

4 Fantásticos).

Y terminaré con la afirmación de la novela de que los científicos ya sabían en 1918 que en el Big Bang se creó tanto materia como antimateria. Algo difícil que lo supieran en ese año, ya que poco antes mencionan que la teoría del Big Bang fue propuesta por

Georges Lemaître en 1927, un dato que sí es verídico, aunque hay que hacer notar que el nombre de Big Bang es posterior (Lemaître la llamaba algo así como "teoría del huevo primigenio"). Por otro lado, la existencia de antimateria era desconocida en aquel entonces.

Mis dos

Mis dos

Supongo que todo el mundo habrá oido hablar de

Supongo que todo el mundo habrá oido hablar de

Vale, en la película, tras el colapso se producía una "onda de choque" (¿mala traducción de "onda expansiva"?) que se expandía como si fuera la onda expansiva de una explosión, arrasándolo todo a su paso. Pero la estrella no explotaba realmente. Se podía ver perfectamente ahí en medio.

Vale, en la película, tras el colapso se producía una "onda de choque" (¿mala traducción de "onda expansiva"?) que se expandía como si fuera la onda expansiva de una explosión, arrasándolo todo a su paso. Pero la estrella no explotaba realmente. Se podía ver perfectamente ahí en medio.

En el

En el  En The Core, los "terranautas" a bordo del vehículo que viaja al núcleo de nuestro planeta, se comunican con la superficie transmitiendo voz sin problemas. En SeaQuest, la cosa va más allá, ya que aunque el submarino esté sumergido, los tripulantes se comunican con el exterior mediante audio y vídeo. Esto es sencillamente imposible, y vamos a ver por qué.

En The Core, los "terranautas" a bordo del vehículo que viaja al núcleo de nuestro planeta, se comunican con la superficie transmitiendo voz sin problemas. En SeaQuest, la cosa va más allá, ya que aunque el submarino esté sumergido, los tripulantes se comunican con el exterior mediante audio y vídeo. Esto es sencillamente imposible, y vamos a ver por qué.

Un ejemplo de esto lo podemos ver en la película

Un ejemplo de esto lo podemos ver en la película  Simplemente voy a comentar un error bastante gordo que ocurre en el número 289 de la edición original de los 4F. En este número (que pertenece a la mítica etapa de

Simplemente voy a comentar un error bastante gordo que ocurre en el número 289 de la edición original de los 4F. En este número (que pertenece a la mítica etapa de

He empezado a leer hace poco

He empezado a leer hace poco

Ayer en

Ayer en  El envío de hoy va a ser algo distinto. No voy a comentar algún error científico en

El envío de hoy va a ser algo distinto. No voy a comentar algún error científico en

Recuerdo concretamente una escena de

Recuerdo concretamente una escena de  Uno podía argumentar que si el satélite está muy bajo sobre el horizonte, entonces se puede obtener una imágen más "natural" (por decirlo de alguna manera). Pero existe el problema de la atmósfera. Al observar algo que se encuentre casi en el horizonte, entre lo que queremos ver y el satélite, hay muchísimo más aire que cuando miramos directamente hacia abajo. Y por muy buenas que sean las capacidades del satélite, la distorsión producida por la atmósfera es demasiado grande. Pensad por ejemplo en cómo vemos el Sol al atardecer. Ese color rojo es debido a la inmensa cantidad de atmósfera que debe atravesar la luz hasta llegar a nosotros. O realizad un simple experimento con unos prismáticos o incluso un telescopio. Observad algo muy muy lejano, que esté en la superficie, y veréis como una especia de neblina o distorsión, que hace que la imágen se vea borrosa y temblorosa. Pero si miráis a la luna llena (y que esé alta), se ve perféctamente.

Uno podía argumentar que si el satélite está muy bajo sobre el horizonte, entonces se puede obtener una imágen más "natural" (por decirlo de alguna manera). Pero existe el problema de la atmósfera. Al observar algo que se encuentre casi en el horizonte, entre lo que queremos ver y el satélite, hay muchísimo más aire que cuando miramos directamente hacia abajo. Y por muy buenas que sean las capacidades del satélite, la distorsión producida por la atmósfera es demasiado grande. Pensad por ejemplo en cómo vemos el Sol al atardecer. Ese color rojo es debido a la inmensa cantidad de atmósfera que debe atravesar la luz hasta llegar a nosotros. O realizad un simple experimento con unos prismáticos o incluso un telescopio. Observad algo muy muy lejano, que esté en la superficie, y veréis como una especia de neblina o distorsión, que hace que la imágen se vea borrosa y temblorosa. Pero si miráis a la luna llena (y que esé alta), se ve perféctamente.